Algoritmos e Desigualdades

Com os algoritmos e inteligências artificiais perpassando tantas esferas da vida humana, observar de forma crítica os aspectos sociais que esta nova realidade traz tornou-se uma responsabilidade do jornalismo. Afinal, em um cenário onde obrigações com impacto direto na vida das pessoas estão sendo progressivamente automatizadas pelas empresas e pelo Estado, é imprescindível compreender as relações que estas tecnologias mantêm com as estruturas de poder. A partir disso, este painel encerrou o terceiro dia da V Conferência Brasileira de Jornalismo de Dados e Métodos Digitais, 4 de novembro de 2020, promovendo um amplo debate sobre a atuação dos algoritmos nas desigualdades sociais.

Mediado pela pesquisadora Sil Bahia, coordenadora do projeto Pretalab, o painel traz um time de peso para a conversa. A professa do MIT e diretora do Data + Feminism Lab, Catherine D’Ignazio, apresenta as análises do seu mais recente livro, Data Feminism, elaborado em parceria com a professora Lauren F. Klein. Joana Varon, diretora-executiva da organização Coding Rights, se junta à discussão trazendo as reflexões sobre capitalismo de dados que são desenvolvidas nos projetos em que é idealizadora. O professor da Northwestern University e autor do premiado livro “Automating the News: How Algorithms are Rewriting the Media”, Nicholas Diakopoulos, completa a mesa contribuindo com seus estudos sobre notícias e algoritmos, produzidos pelo Laboratório de Jornalismo Computacional que dirige na universidade.

Assista com tradução simultânea do inglês para o português

Por dentro do feminismo de dados

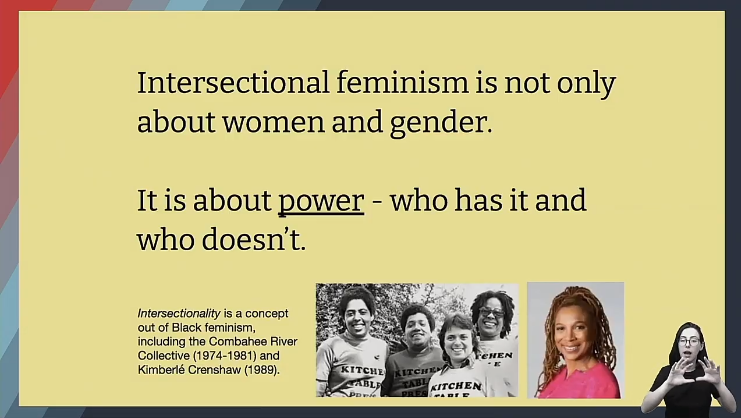

Catherine D’Ignazio inicia sua apresentação traçando uma definição clara sobre o que é o feminismo de dados e o que esta corrente reivindica. Segundo a autora, a ideia é responsabilizar empresas e governos pela produção de dados que reproduzem opressões estruturais. “Parte da motivação para o feminismo de dados vem como uma onda de resistência contra esses produtos com dados racistas, classistas e sexistas”, afirma.

A professora critica a visão dos dados como um novo petróleo (data is the new oil). A comparação, utilizada pela primeira vez no jornal The Economist, parte da premissa que, assim como os recursos da natureza, os dados estão sendo usados como uma fonte de rendimento para muitas organizações. Nesta perspectiva, “os dados são semelhantes a um recurso natural: algo que pode ser garimpado, extraído, captado, depurado e processado, e no final transformado em lucro”, pontua Catherine. Porém, ela indaga: “Lucro para quem? Quem se beneficia com esses dados?”

Para Catherine D’Ignazio, os dados são o poder nos dias de hoje e, justamente por isso, replicam as desigualdades que existem há séculos. “Os dados são a mesma velha opressão de sempre, apenas com uma roupagem nova.” Assim, a tarefa do feminismo de dados é trazer um olhar interseccional para a ciência de dados, compreendendo que ela não é apenas sobre as questões de gêneros, mas sobre a estrutura de poder que atua em cima de todas as minorias.

O uso dos algoritmos para a imposição de normatividades

Joana Varon é diretora da Coding Rights, uma organização brasileira que desenvolve trabalhos sobre tecnologia e assimetrias de poder, a partir de um enfoque nas questões de gênero e interseccionalidades. Ela começa sua exposição defendendo a tese de que os dados são utilizados para manipular e impor normatividades partindo de um exemplo simples: como os algoritmos do Instagram, sem motivo aparente, passaram a mostrar conteúdos sobre bebês e maternidade para sua companheira.

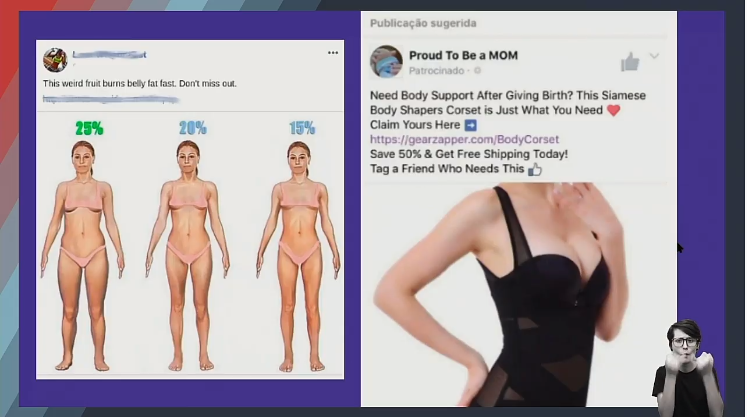

A pesquisadora apresenta a teoria de Patricia Hill Collins na obra “Black Feminist Thought” para ilustrar a lógica do capitalismo de dados. Segundo Collins, existe uma matriz de dominação que atua em conjunto para a manutenção do capitalismo, do colonialismo, do heteropatriarcado e da supremacia branca. Dessa forma, os dados, criados por pessoas inseridas nesta estrutura e nas mãos de companhias que lucram com essas opressões, funcionam como uma ferramenta silenciosa de perpetuação da normatividade.

Por meio da exposição de levantamentos do projeto Chupadados, que pesquisa a influência dessa lógica capitalista nas interações com a tecnologia, Joana afirma que os papéis de gêneros são reforçados pelos algoritmos em forma de publicidade direcionada, mais implícitas do que as propagandas de antigamente. Mas quando isso foi autorizado pelos usuários? “A gente está privada da possibilidade de dizer ‘não’, e como tal, não pode haver um consentimento se você está privada do não, porque a consequência é a exclusão digital”, conclui.

Como transformar algoritmos em pautas

O professor Nicholas Diakopoulos propõe, a partir dos estudos que desenvolve no Laboratório de Jornalismo Computacional da Northwestern University, formas de responsabilizar empresas responsáveis por algoritmos por suas falhas, transformando-os em notícias. “Na prática, a responsabilização algorítmica não é apenas o lado técnico dos algoritmos. Os algoritmos precisam ser entendidos como compostos tecnológicos também formados por pessoas”, explica. Nicholas destaca a importância de se questionar como essas pessoas exercem o seu poder através do sistema algorítmico.

O autor argumenta que os algoritmos podem facilmente infringir direitos humanos em decorrência dos vieses que foram passados a eles por quem os criou ou pelos conjuntos de dados utilizados. Nesses casos, existem pautas não só boas, como necessárias. Nicholas expõe uma série de exemplos de situações assim, como nos casos em que um algoritmo nega falsamente um benefício do governo a alguém ou quando atribui uma pontuação de crédito errada que impede alguém de adquirir um empréstimo.

Nicholas Diakopoulos alerta para o perigo com as coletas de dados tendenciosos, pois a transferência de vieses ao algoritmo se dá, primeiramente, através desses bancos de informações. Como os algoritmos de inteligência artificial aprendem por meio de exemplos, um viés discriminatório processado no início do código facilmente influencia os modos como o sistema toma decisões. “Os algoritmos estão na singular posição de realmente perpetuar os vieses sistêmicos como racismo e o sexismo; e como os algoritmos podem ganhar escala e serem aplicados a muitas pessoas, há o perigo deles amplificarem e reforçarem alguns dos piores vieses da sociedade.”

Quem cabe no futuro?

Após as apresentações, os painelistas debateram sobre como democratizar o acesso a essas informações. Sil questiona: “Como a gente cria pontes entre questões mais técnicas sobre a tecnologia e questões sociais que também são atravessadas pela tecnologia?”.

Para Catherine, “o conjunto de dados que nós herdamos são centenas de anos de opressão”. Dessa forma, é necessário criar coalizões maiores e diversas para trabalhar com esses agrupamentos sociais.

Já Joana acrescenta que a solução pode estar na narrativa, em construir um bom storytelling, pois as discussões sobre tecnologias foram afastando as pessoas, formando bolhas que são feitas com um propósito. “Somos todos apropriados a pensar sobre as tecnologias”, afirma a pesquisadora.

E Nicholas acrescenta que é necessário pensar em uma estrutura de governança sobre esses sistemas e construir pontes entre engenheiros, técnicos e sociólogos.

Catherine D’Ignazio

Catherine D’Ignazio é professora assistente de Ciência Urbana e Planejamento no Departamento de Estudos Urbanos e Planejamento do MIT e diretora do Data + Feminism Lab.

Joana Varon

Nicholas Diakopoulos

Sil Bahia

REALIZAÇÃO

DESENVOLVIDO COM

APOIO

APOIO DE MÍDIA